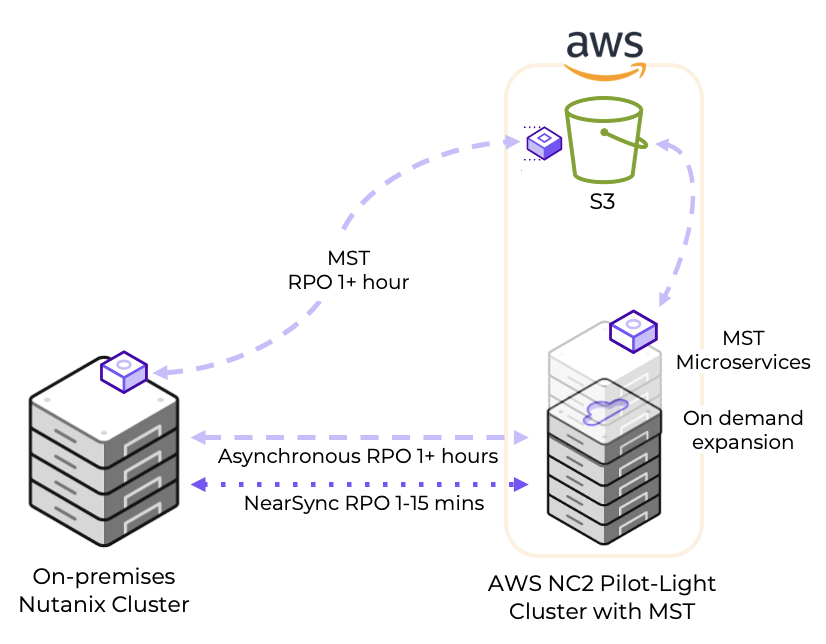

オンプレミスからNutanix Cloud Clusters (NC2) on AWSへの災害復旧 (Disaster Recovery, DR) の設定は簡単で、事業継続性を確保する責任を負う方々に大きなメリットを提供します。Pilot Lightクラスタを利用することで、リカバリー時間目標 (RTO) が異なる2つのレベルのワークロードに対応しつつ、通常運用時のNC2クラスタサイズを最小化することでコストを削減できます。このDR設定は、Nutanix MST(Multicloud Snapshot Technology)を活用しています。

Pilot Lightクラスタを使用する理由

災害発生時にはすべてのワークロードが重要で回復が必要ですが、それぞれが異なる回復時間要件を持つ場合があります。短い回復時間を必要とするアプリケーションやサービスについては、Nutanixの組み込みDRツールを使用してオンプレミスから小規模なNC2 on AWSクラスタへのレプリケーションを設定してください。

一方、少し長めのRTOで問題ないワークロードの場合、Amazon S3にレプリケートすることで運用コストを削減できます。災害時には、これらのワークロードをS3からNC2 on AWSクラスタにリカバリーします。この方法は、通常運用時に小規模かつコスト効率の高いNC2 on AWSクラスタを維持し、S3からワークロードを回復する必要がある場合にクラスタをスケールアウトする柔軟性を提供します。

ゼロコンピュートオプション

さらに、NC2 on AWSを使用したゼロコンピュートDR戦略を構成することも可能です。この場合、NC2クラスタは存在せず、オンプレミス環境がAmazon S3にデータを直接レプリケートします。ただし、このトピックは別のブログ投稿で取り上げます。

ゼロコンピュートDRは、Pilot Lightよりも運用コストをさらに削減できます。NC2クラスタを展開する必要がないためです。しかし、災害発生時にNC2インフラストラクチャをプロビジョニングする必要があるため、RTOは長くなります。したがって、ゼロコンピュートは運用コストの観点では安価ですが、災害時の復旧クラスタの展開と構成に時間がかかるため、事業への影響コストが高くなる可能性があります。

ソリューションアーキテクチャ

以下の図は、Amazon S3とNC2 on AWSクラスタの両方にレプリケートできる方法を示しています。それぞれ異なるRPO時間を持っています。

展開手順

Pilot Lightクラスタの構成は数時間で完了できます。本ブログ投稿では、以下のステップを通じて設定を進めました:

ステップ1: NC2 on AWSクラスタを展開し、DRを有効化

NC2ポータルで数回クリックするだけで、このプロセスを実行できます。既存のAWS VPCに展開するか、クラスタ展開中に新しいリソースを作成することが可能です。オンプレミスとの接続性がある既存のVPCを使用する場合、ルーティングがすでに構成されているため、セットアップがさらに迅速に進みます。

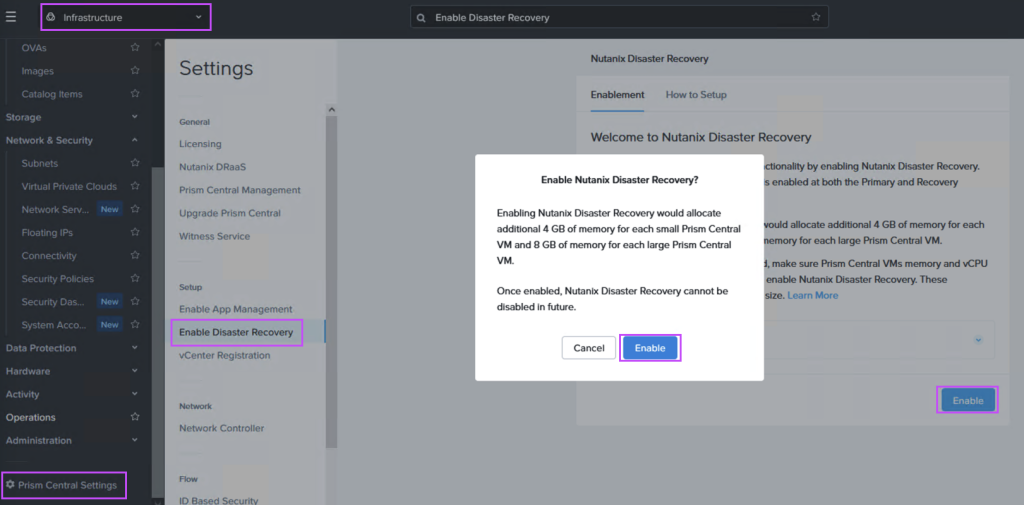

Prism Centralの設定メニューに移動し、以下のようにDisaster Recoveryを有効化してください:

ステップ2: オンプレミスとAWS間の接続性を追加(未設定の場合)

Direct ConnectまたはS2S VPNを構成し、オンプレミスのNutanixクラスタ環境とNC2 on AWSを保持するAWS VPCをリンクします。

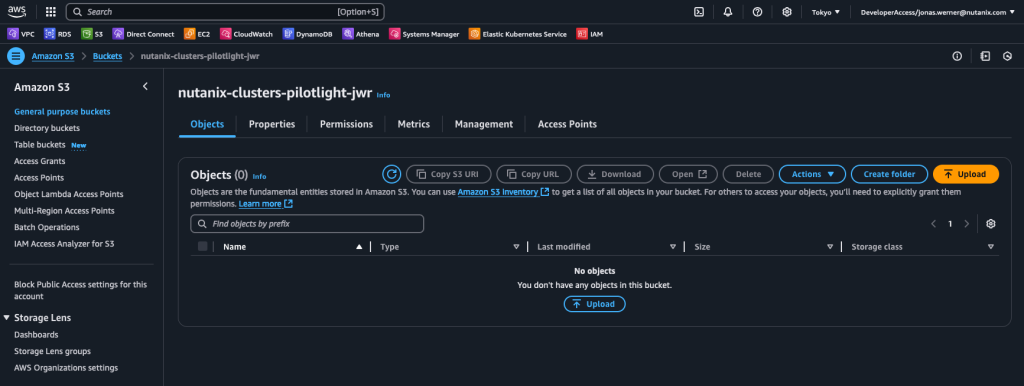

ステップ3: レプリケートデータを保存するS3バケットを作成

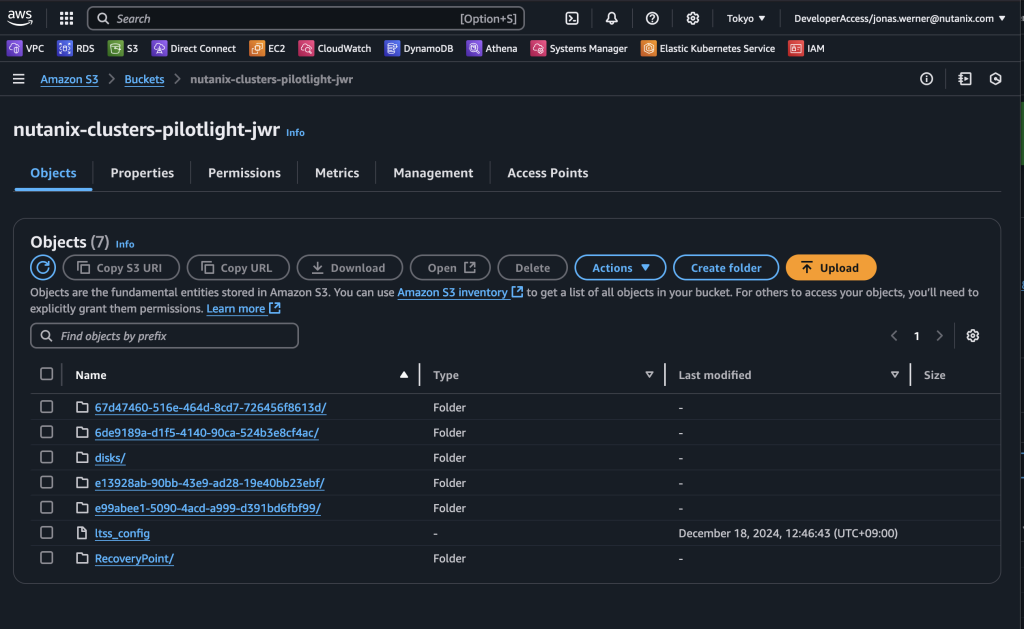

NC2 on AWS環境からアクセス可能なS3バケットを作成します。「nutanix-clusters」で始まる名前を付けることを推奨します。他のバケットと区別するために追加の名前を加えてください。この例では「nutanix-clusters-pilotlight-jwr」という名前を使用します。

作成されていない場合、このバケットへのフルアクセス権限を持つユーザーを作成し、アクセスキーとシークレットアクセスキーを記録してください。以下は、バケットへのフルアクセス権限を付与するポリシーの例です:

{

"Version": "2012-10-17",

"Statement": [

{

"Sid": "FullAccessForMstToSpecificS3Bucket",

"Effect": "Allow",

"Action": [

"s3:*"

],

"Resource": [

"arn:aws:s3:::nutanix-clusters-pilotlight-jwr",

"arn:aws:s3:::nutanix-clusters-pilotlight-jwr/*"

]

}

]

}

ステップ4: NC2 on AWSのPrism CentralでMSTを構成

MSTは複数の仮想マシンをデプロイします。このデプロイには、AWSネイティブVPCのCIDR範囲内で3つのIPアドレスを指定する必要があります。

NC2がAWSネイティブネットワーキングで展開された場合、既存ネットワークのDHCP範囲外のIPアドレスを指定するか、Prism Centralコンソールを使用して新しいAWSネイティブサブネットを追加します。

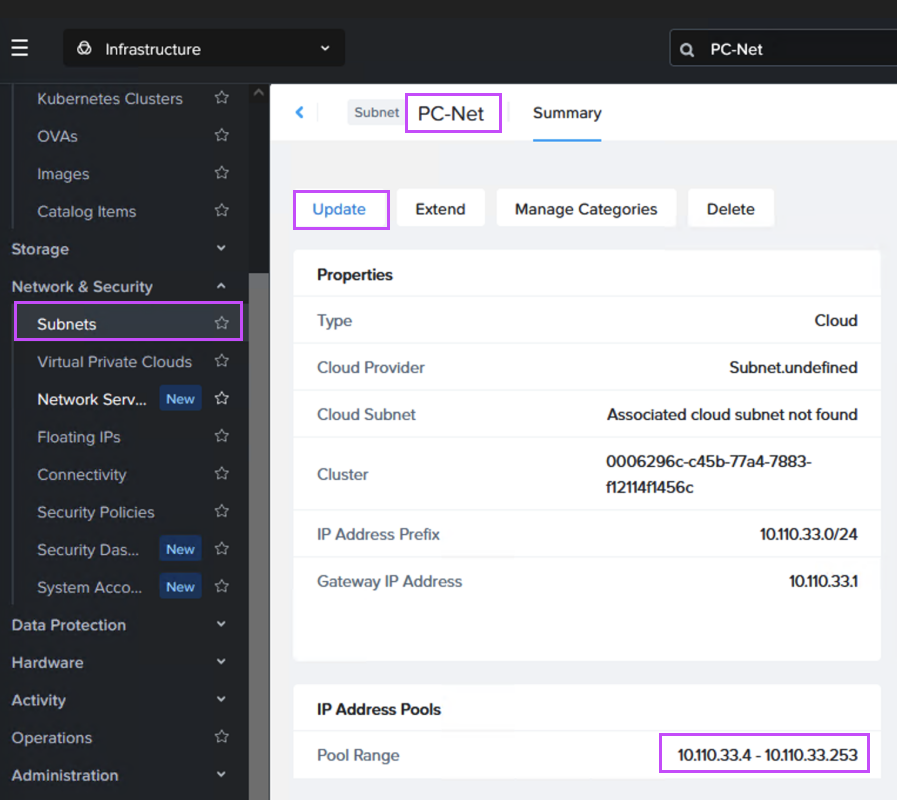

Flow Virtual Networking (FVN) を使用して展開された場合、「PC-Net」のDHCP範囲を縮小してMST用のスペースを確保するのが最も簡単です。ここでは、最後のIPアドレスを”10.110.33.253”から”10.110.33.200”に変更しています。確保するIPアドレスを使用している仮想マシンが存在しないことを確認してください。

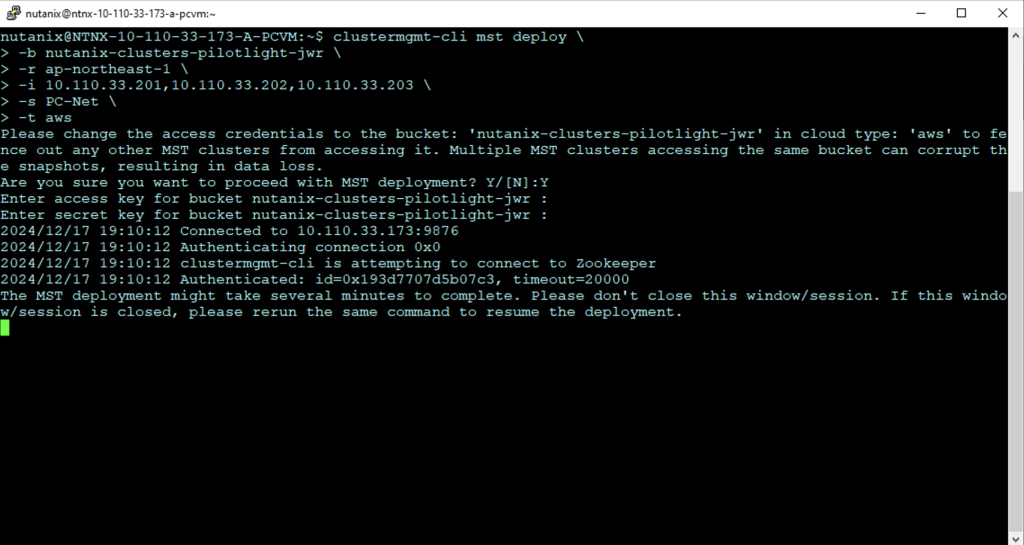

Prism Centralで「nutanix」ユーザーを使用してSSHまたはコンソールウィンドウを開き、以下のコマンドを入力してデプロイを開始します:

clustermgmt-cli mst deploy \

-b <BUCKET NAME> \

-r <AWS REGION> \

-i <IP#1>,1<IP#2>,<IP#3> \

-s <NC2 NETWORK NAME> \

-t <BUCKET TYPE (aws or ntx_oss)>例:

clustermgmt-cli mst deploy \

-b nutanix-clusters-pilotlight-jwr \

-r ap-northeast-1 \

-i 10.110.33.201,10.110.33.202,10.110.33.203 \

-s PC-Net \

-t aws

デプロイが開始され、以下のように進行状況が表示されます。プロンプトが表示されたら、S3バケットにアクセスする権限を持つユーザーのAWSアクセスキーとシークレットアクセスキーを入力してください。

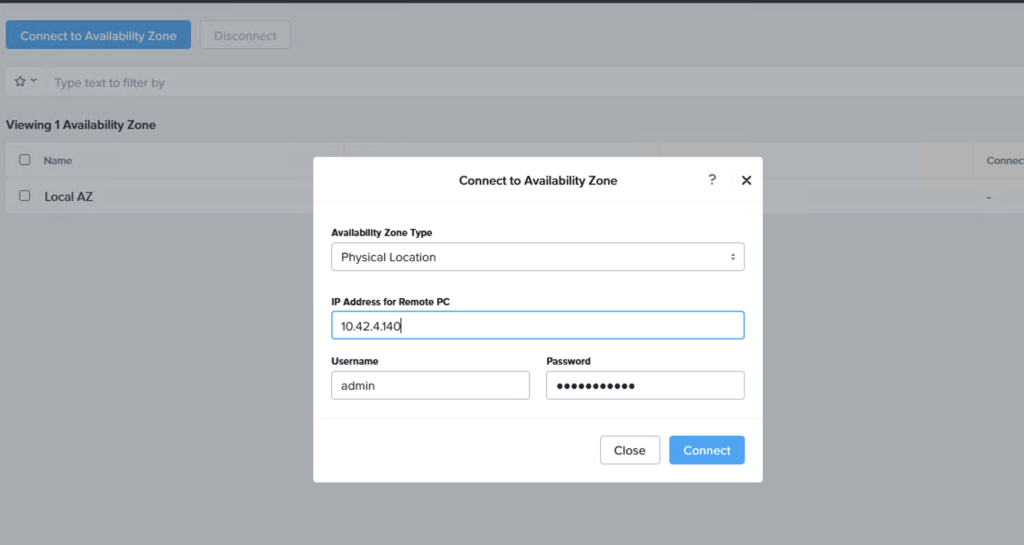

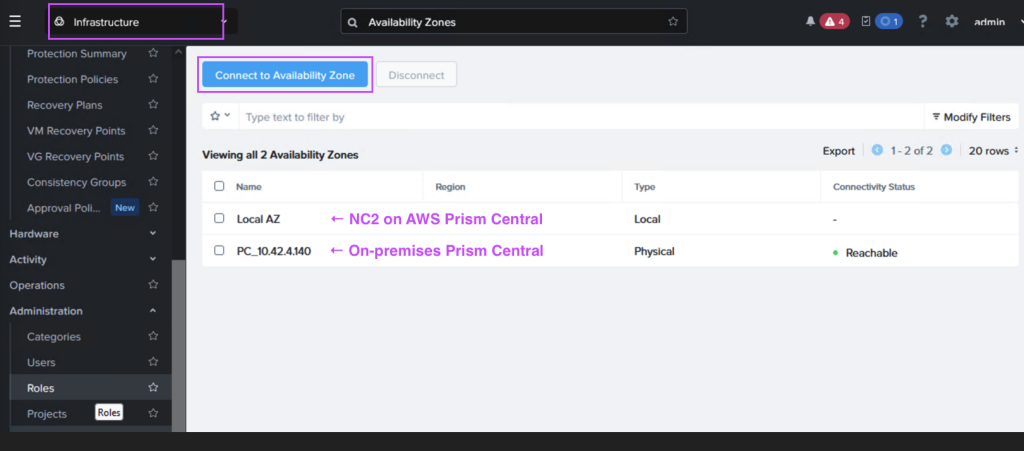

ステップ5: オンプレミスのPrism CentralとNC2のPrism Centralをリンク

オンプレミスまたはNC2のPrism Centralで、「Administration」 > 「Availability Zones」に移動し、別のPrism Centralインスタンスをリモート物理サイトとして追加します。

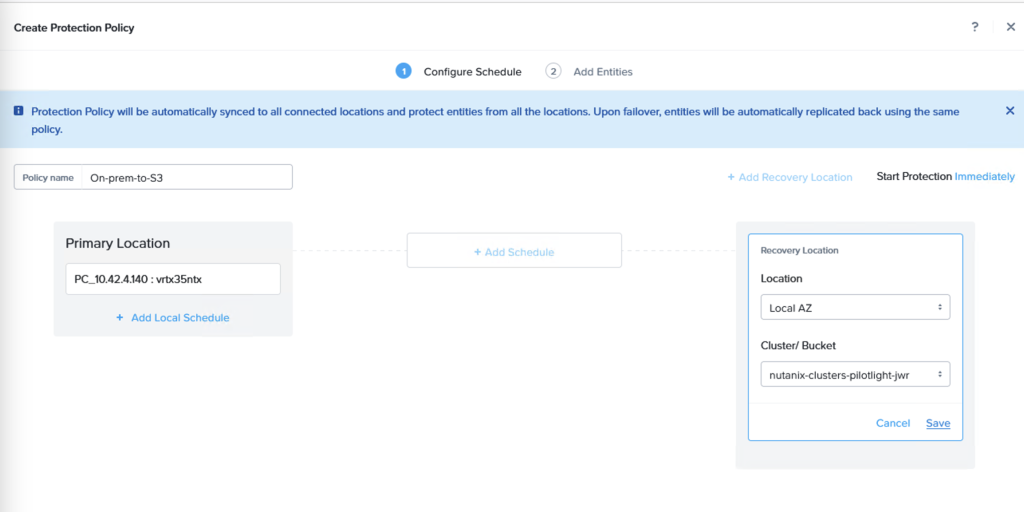

ステップ6: 保護ポリシーとDRプランを作成

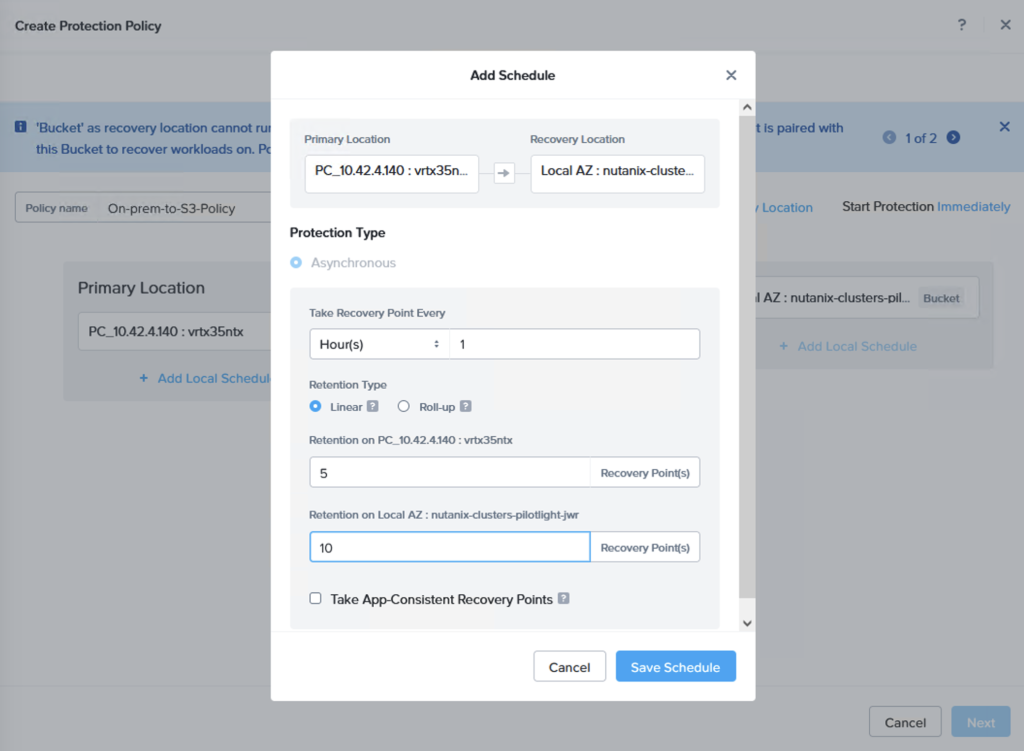

Prism Centralコンソールで「データ保護」 > 「保護ポリシー」に移動します。ここから、新しい保護ポリシーを作成します。オンプレミスのクラスタをソースに、Amazon S3バケットをターゲットとして指定します。

レプリケーションスケジュールを設定し、最大36個のスナップショットを保持するリニアスナップショット、または最大1か月のデータ保持が可能なロールアップを選択できます。

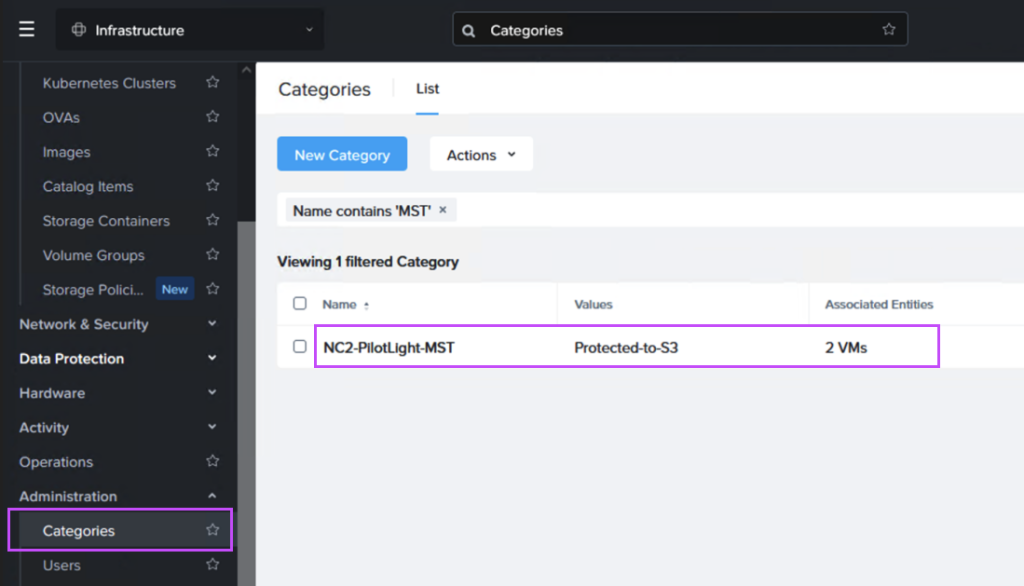

次に、リカバリプランを作成します。オプションとして、Amazon S3に送られるVMとNC2クラスタに直接レプリケートされるVMをグループ化するために、2つのカテゴリを作成します。以下は、S3にレプリケートされるVMグループのカテゴリ例です。

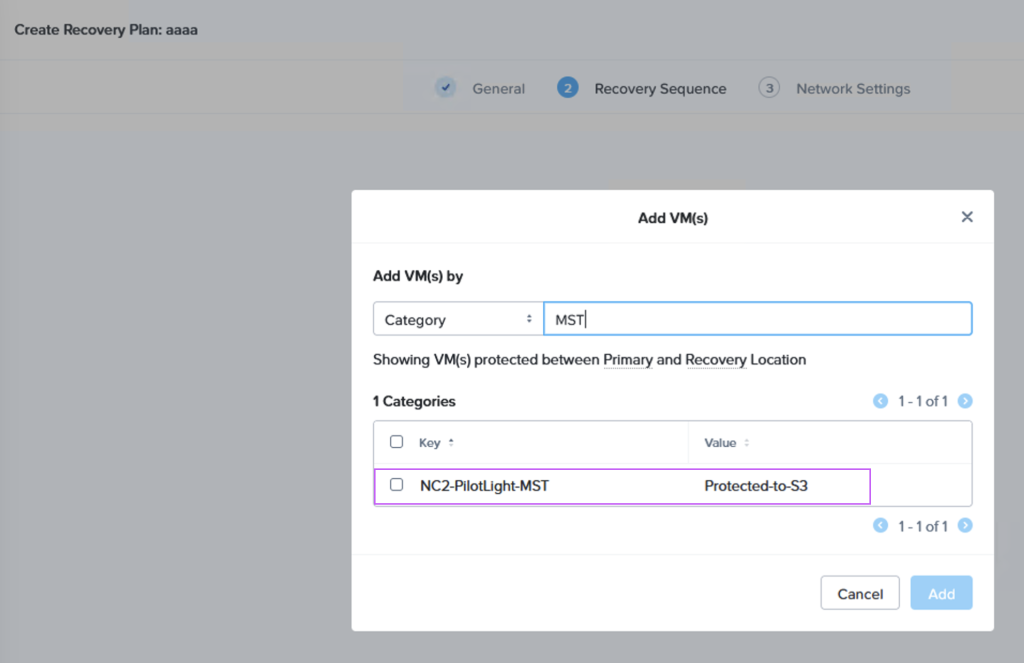

その後、「データ保護」 > 「リカバリプラン」に移動し、カテゴリを参照して、正しいVMが正しい場所にレプリケートされるよう設定します:

S3へのデータレプリケートを確認 + フェイルオーバー

これでレプリケーションスケジュールが設定され、カテゴリを通じてターゲットVMが強調表示され、レプリケートされることが保証されます。S3バケットを確認することで、オンプレミスのクラスタからS3にスナップショットが送信されたことを確認できます。

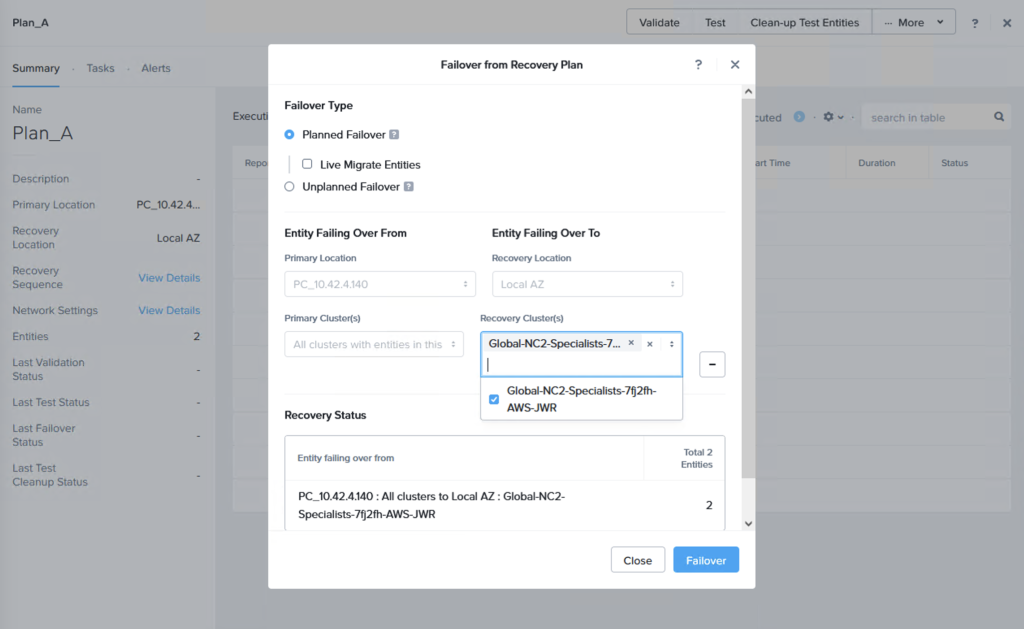

この時点でフェイルオーバー、またはテストを行い、レプリケートされたデータからの復旧が可能であることを確認できます。これを行う際、S3のデータからフェイルオーバーするため、VMを復旧するターゲットクラスタを選択する必要があります。「+ Add Target Clusters」をクリックし、以下のようにNC2 on AWSクラスタを選択します:

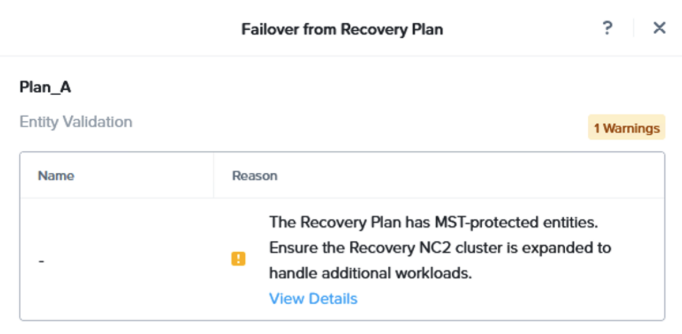

警告が表示され、S3から復元されるVMの流入を処理するためにNC2 on AWSクラスタに追加ノードを必要とする場合があることを強調されます。必要に応じて、NC2管理コンソールを使用してノードを追加することでクラスタを拡張します。

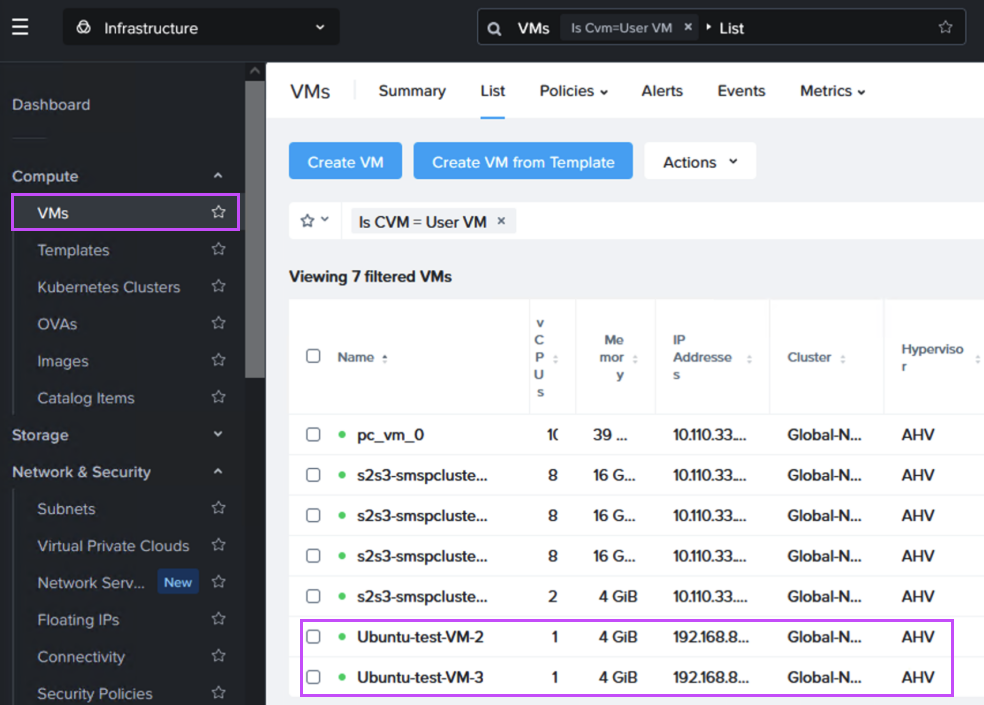

フェイルオーバー後、VMがNC2 on AWSで問題なく稼働していることを確認できます。

まとめ

この記事では、NC2 on AWSのPilot Lightクラスタを使用した災害復旧の設定方法についてガイドとデモンストレーションを行いました。詳細については、以下のドキュメントリンクを参照してください。この内容が分かりやすかったことを願っています。具体的な使用事例や環境についてさらに情報が必要な場合は、お近くのNutanix担当者にお問い合わせください。